本地大模型工具Ollama+OpenWeUI部署图文流教程

前言

最近我的老师给我推了一下本地大模型部署工具Ollama的介绍视频,以前都是觉得用用GPT这些AI公司的产品就很好了,并不觉得部署一个这样的本地大模型有什么用,跑起来又没直接用GPT的效果好,但是我忽略了一个问题:假如你是在企业办公,又想让AI来帮助你提高生产力,那你总不能直接把公司内部文件放到GPT上让AI去帮你分析吧??数据全留到AI公司的数据库去了,你公司真谢谢你勒!!那为了解决这个需求,我认为本地大模型部署工具Ollama的出世就为这一痛点提供了解决方案。那话不多说,我们就开始部署教程的讲解吧!!

前置工作

-

1.本次部署教程的环境是Windows系统

-

2.DockerDesktop环境

DockerDesktop的环境安装比较麻烦,一不小心就容易出现奇奇怪怪的错误,对此我在上篇文章已经写过DockerDesktop的部署教程了,如果自己电脑上没有DockerDesktop的建议移步这篇文章:Windows环境的DockerDesktop的部署

安装Ollama

首先我们打开Ollama官网,如图1所示,打开之后我们点击Dowload

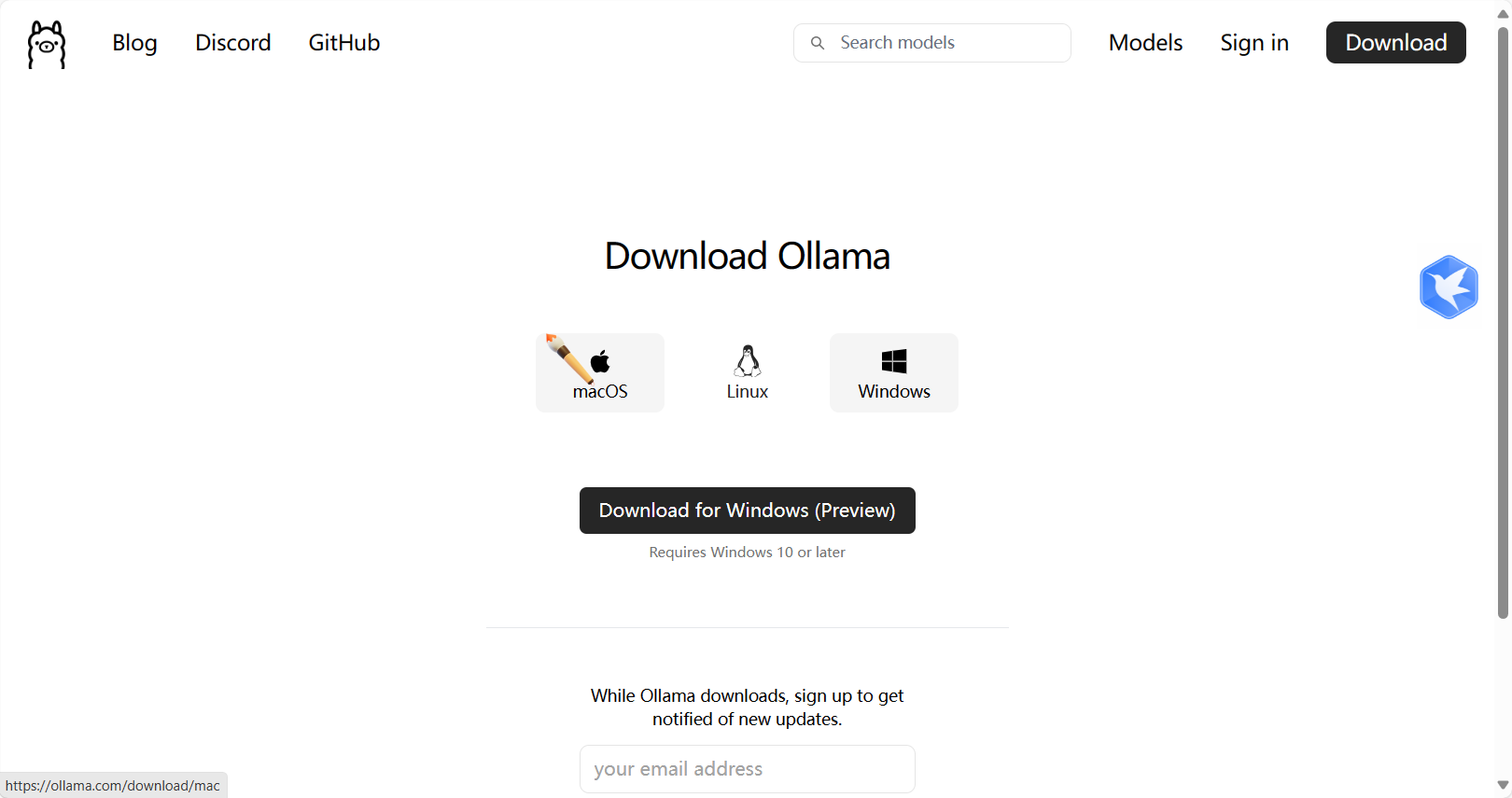

进入Download,我们可以看到如图2的界面,你们可以根据你们电脑所使用的操作系统点击图中对应的图标下载即可,本教程的环境是windows环境,所以我点击Dowload for Windows(Preview)按钮进行下载。

点击之后我们进入如图3的页面, 我们点击install进行安装即可。

安装完毕之后Ollama将会自动启动:

配置Ollama(Optional)

由于Ollama会自动将大模型文件保存在C盘,所以接下来我们将通过修改系统环境变量配置一下Ollama所保存的大模型文件路径以防C盘爆炸,如果你觉得你的C盘非常充裕,那么你可以跳过这步。

新建大模型文件夹

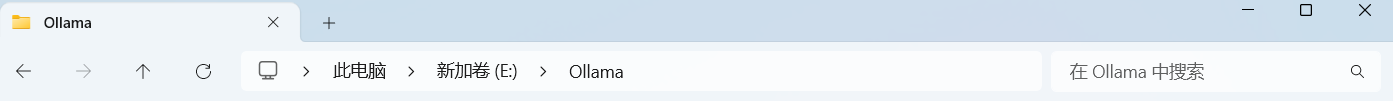

我们将在空间充裕的盘新建一个名叫Ollama的文件夹来容纳大模型文件,这里我是在E盘创建了一个Ollama文件夹:

记住这个文件夹路径!!!我们后续将会用到

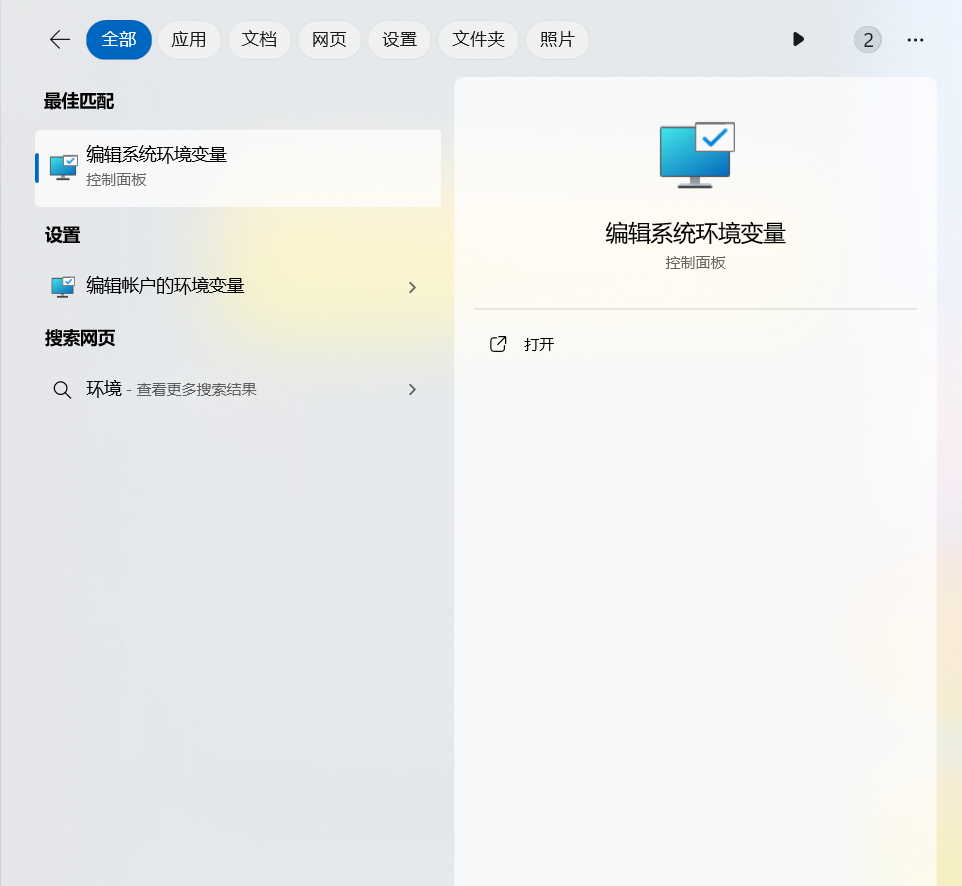

进入环境变量

首先我们在系统搜索栏搜索环境变量:

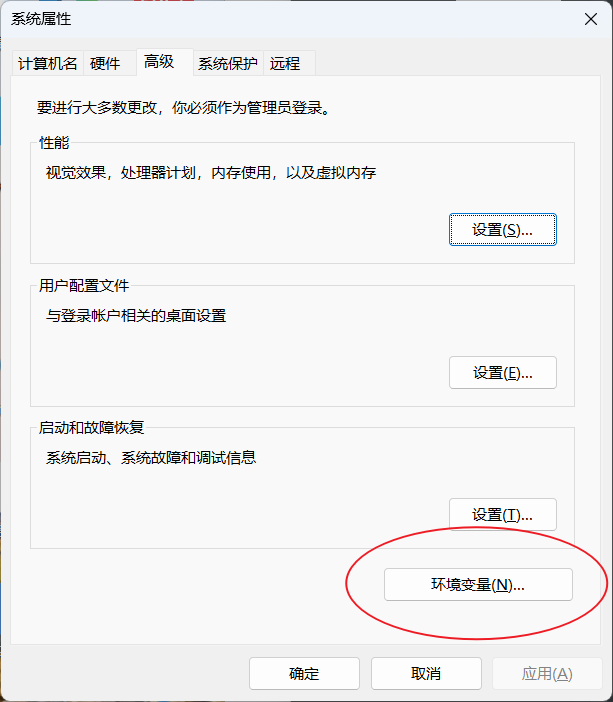

点击打开即可,打开之后我们点击下图中画圈的环境变量选项即可:

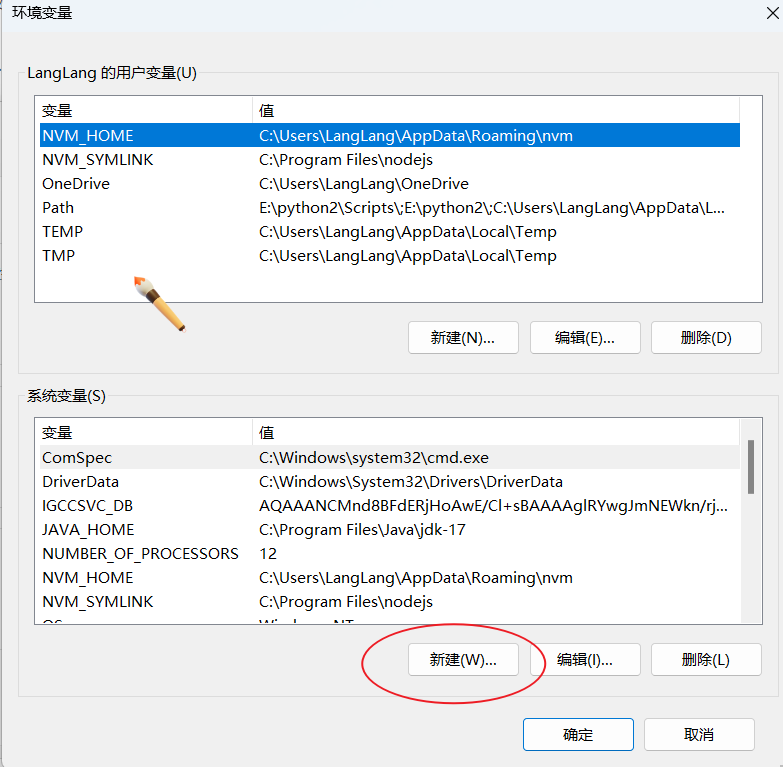

好的,我们现在已经进入环境变量编辑页面了,我们点击下图中新建选项:

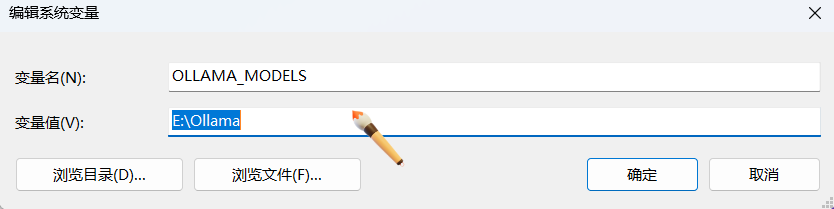

这里我们在变量名统一写:

OLLAMA_MODELS变量值则去找到刚刚我们在上面新建的大模型文件夹的路径复制粘贴来即可,我新建的位置是在“E:\Ollama”,所以我变量值填入E:\Ollama。你可以根据你新建的Ollama文件夹路径灵活进行填写。

完成之后我们点击确定即可!

拉取大模型

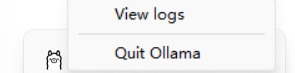

在拉取大模型之前我们先在小窗口点击Quit Ollama,然后再打开Ollama让我们在上面环境变量配置的大模型拉取路径生效:

选取大模型

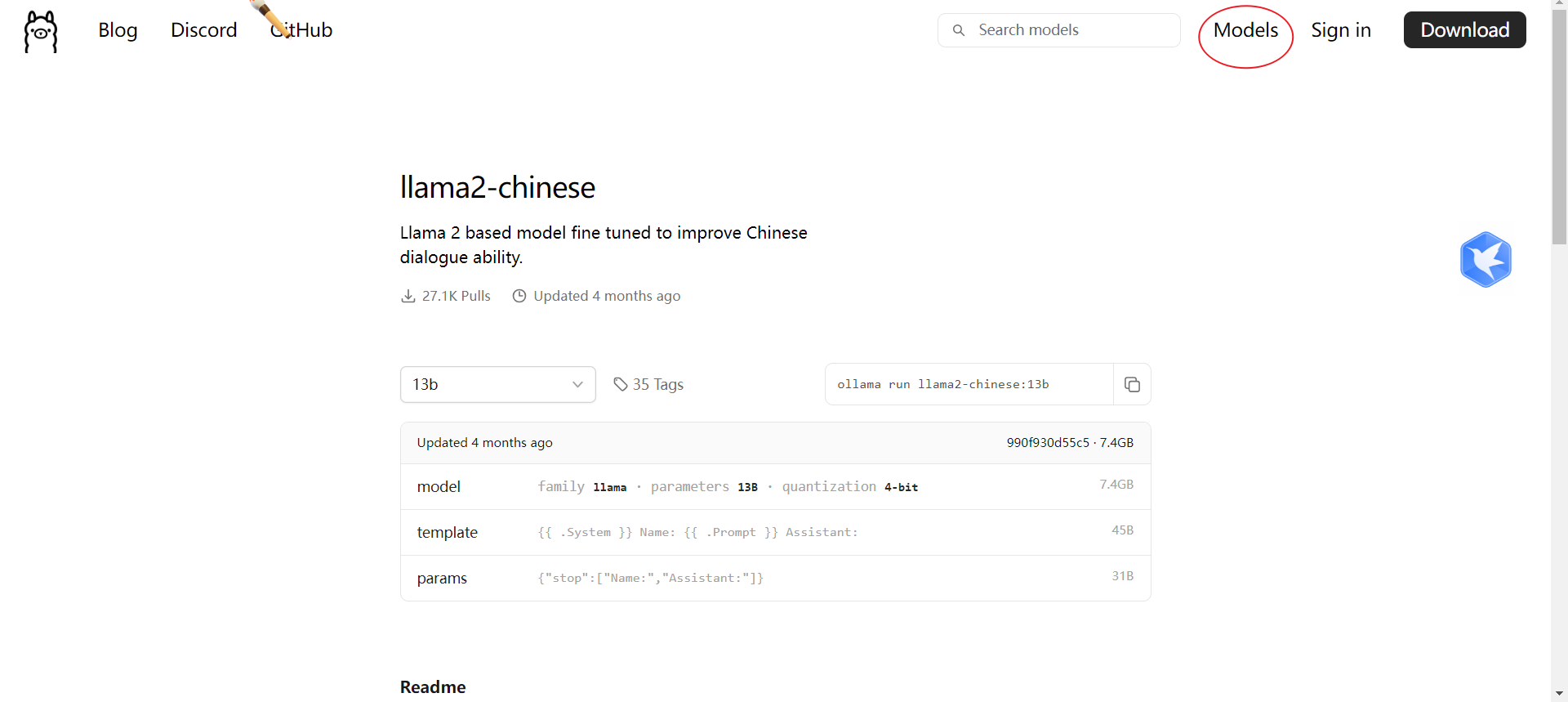

我们可以在Ollama官网点击Models去选择你喜欢的模型即可

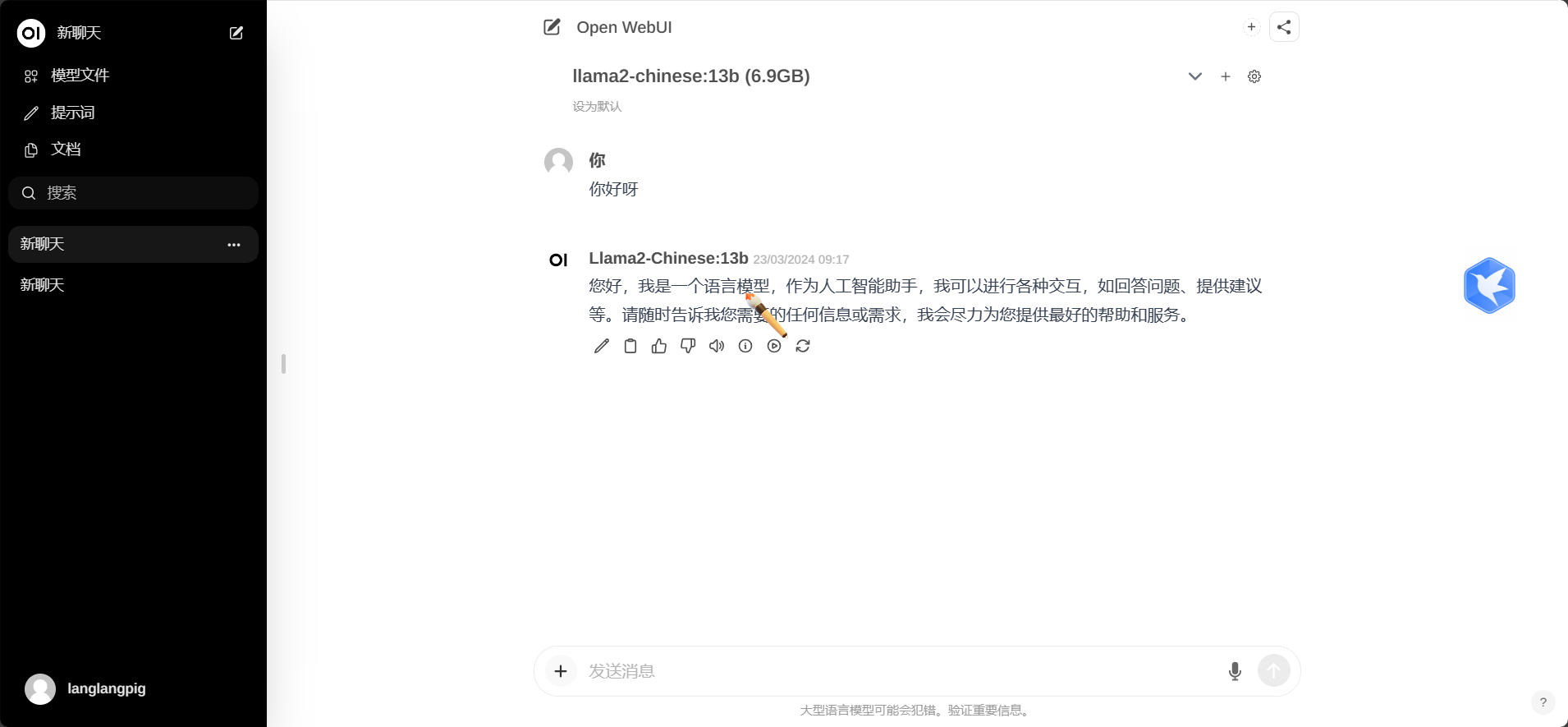

这里我选择的是llama2-Chinese模型,这个版本是经过中文微调的,对中文的支持比较好,其余的llama2模型基本上你用中文问一句他就时不时会冒出英文来,体验感不是很好。

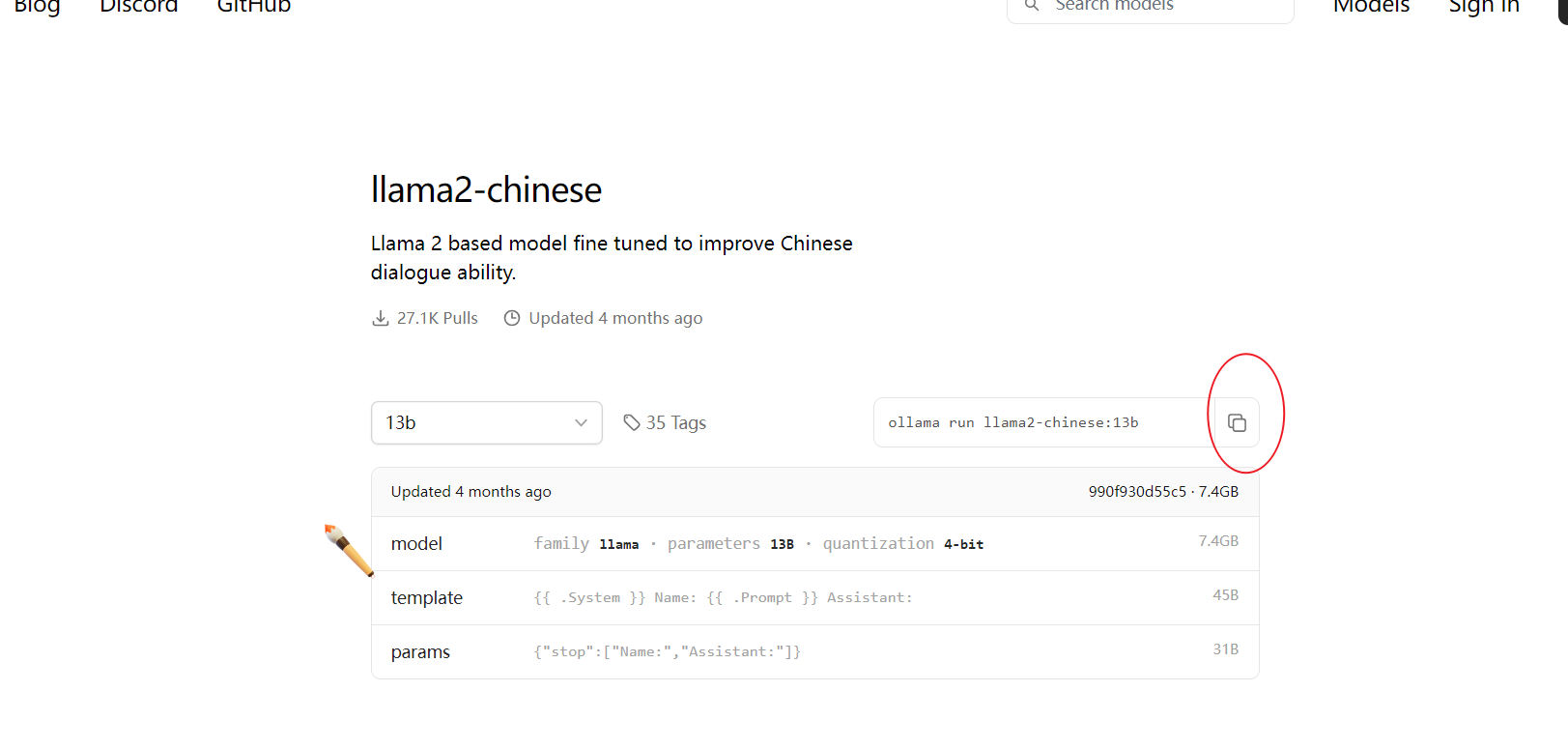

接下来我们点击下图中画圈的按钮复制大模型拉取命令即可:

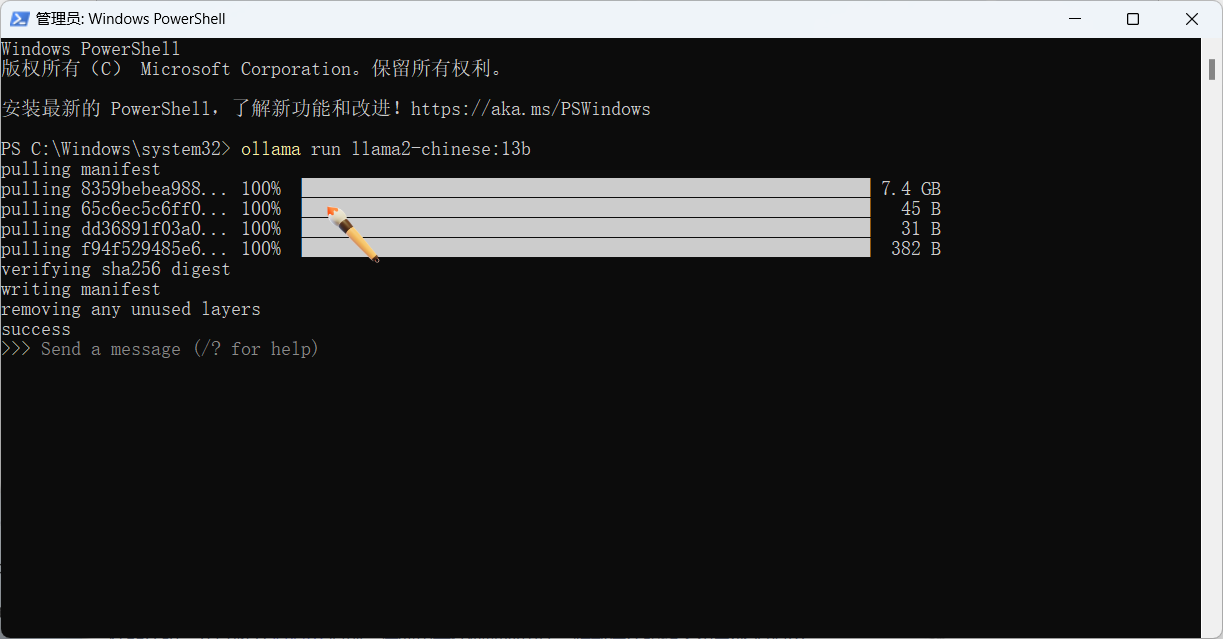

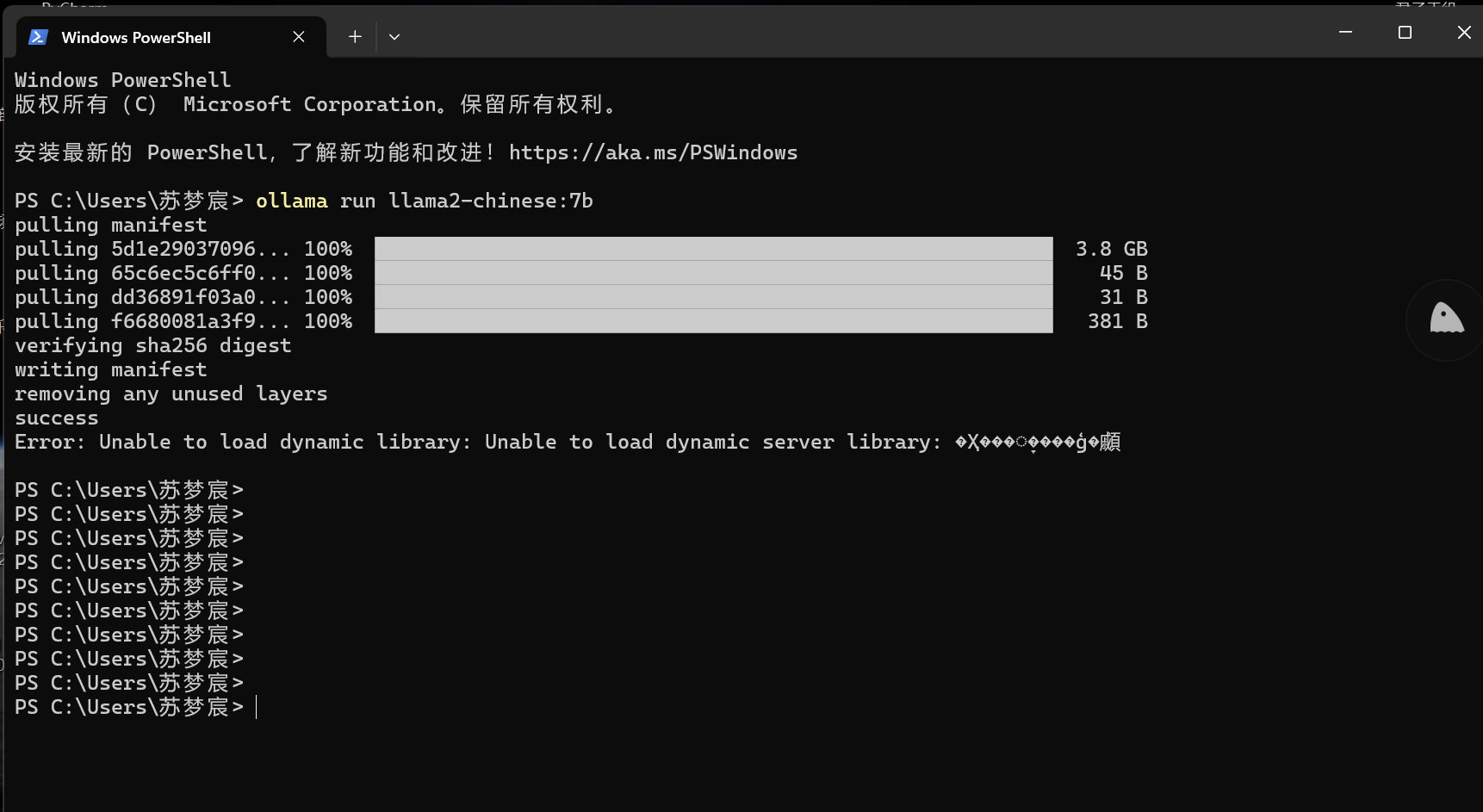

复制之后我们将命令粘贴到PowerShell命令行中运行即可,首次运行Ollama将会自动拉取大模型。

模型拉取成功的结果如下图所示:

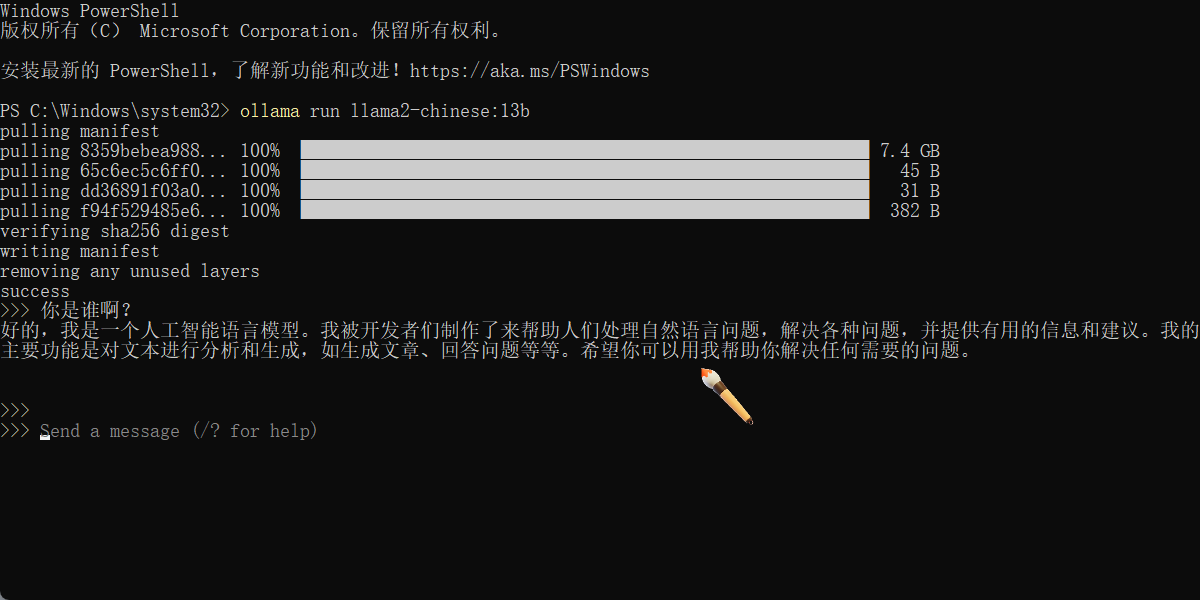

这里我们可以直接在命令行里输入你想问的问题来测试一下大模型:

这里要说明一下:Ollama在运行的时候会自动检测系统是不是有GPU,有GPU的话他会自动启动GPU来加速推理速度来回复你的问题!!

Okey!!我们大模型已经安装完毕了,如果你不小心关闭了当前的PowerShell命令行,那你只要输入我们在拉取大模型的时候复制的命令行语句重新运行即可(我们已经拉取过大模型了,所以我们再次输入这个语句就是单纯的运行了,而不会再次下载大模型)。

部署OpenWebUI

要提高生产力, 我们总不能像原始人一样在命令行上问来问去吧,太low了!效率不够高,所以我们通过OpenWebUI来实现大模型的Web页面问答。

安装OpenWebUI

根据OpenWebUI官网的推荐安装模式是通过docker进行部署,这就是为什么我们的前置工作需要安装DockerDesktop的原因。

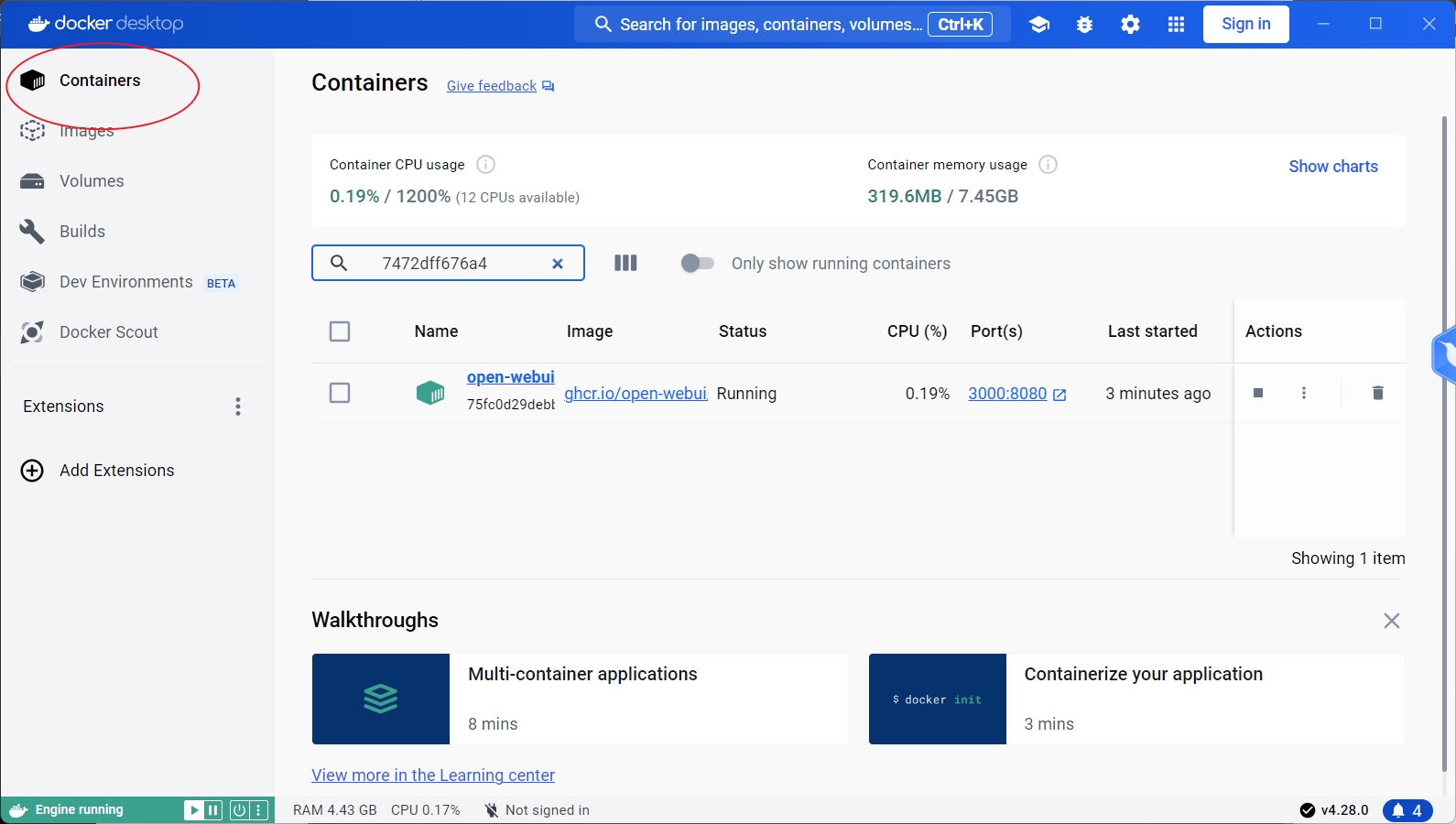

首先我们打开DockerDesktop,让其处于运行状态!!!!!这一步很重要!!

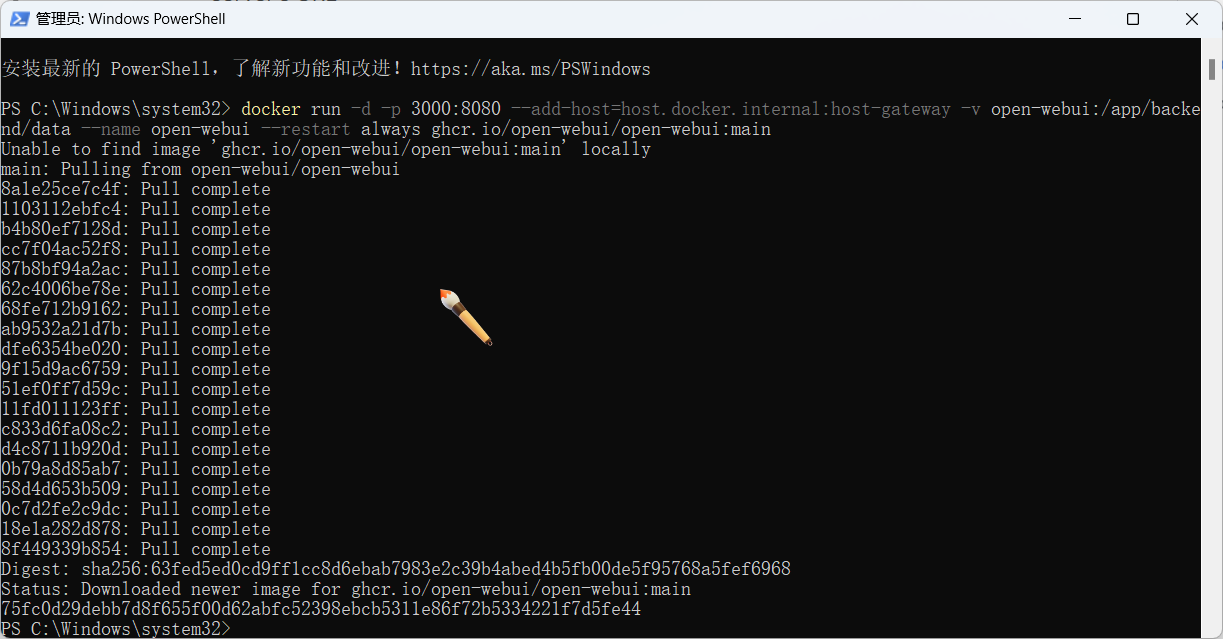

然后我们再次以管理员身份运行PowerShell,输入以下docker语句进行OpenWebUi的镜像拉取:

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main在命令行输入之后按两下回车,系统就会开始拉取镜像了。

看到下图的结果,就表明我们OpenWebUI的镜像就已经拉取完毕了:

接下来我们直接访问OpenWebUI默认的映射端口进行访问:

http://localhost:3000配置OpenWebUI

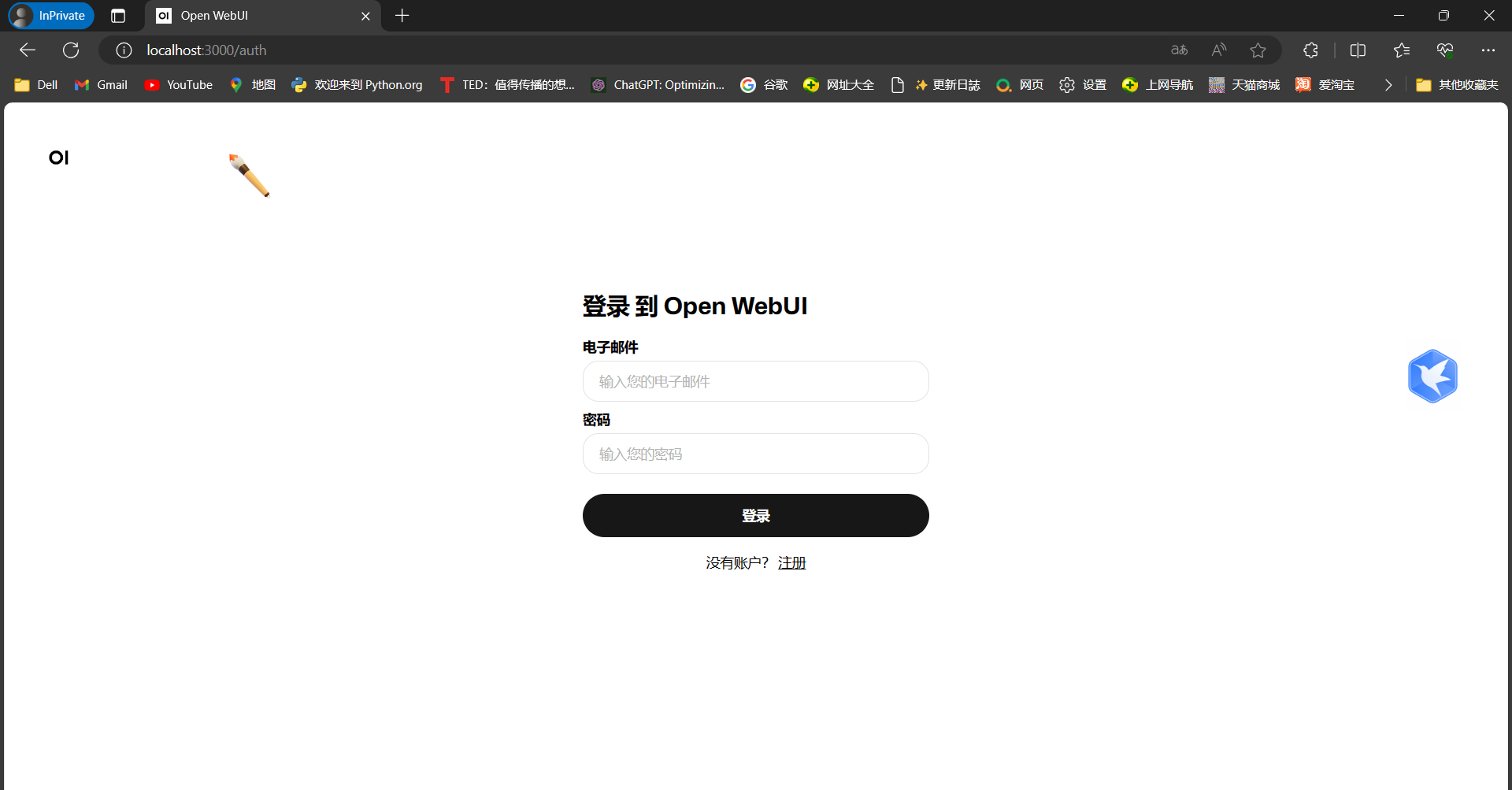

我们进入OpenWebUI的默认访问端口之后我们会看到如下页面:

首次进入我们点击注册,给自己注册一个账号即可,放心,数据将全部保存在本地,不会外传。

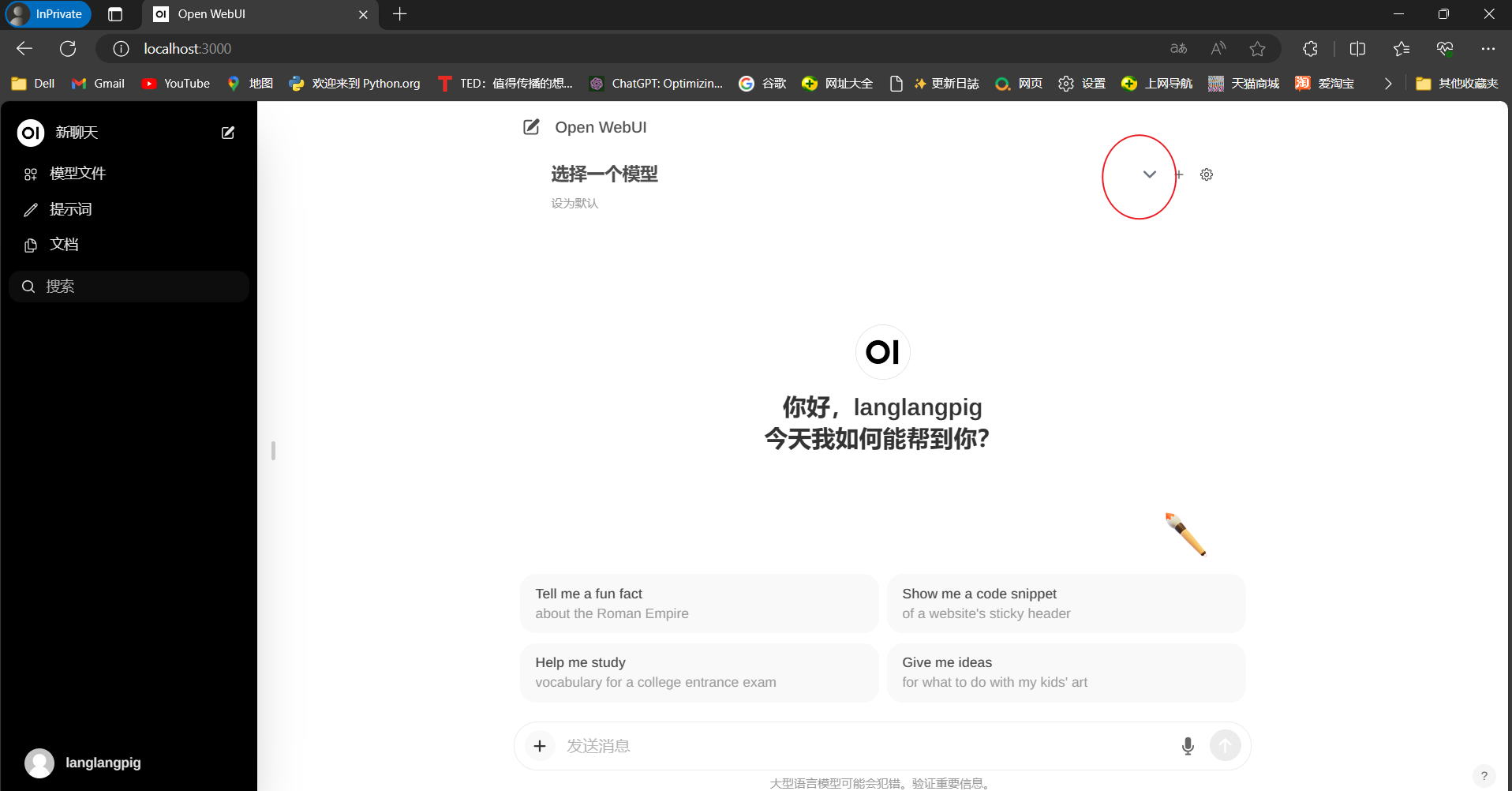

注册之后我们进入到主页面,点击下图画圈部分选择我们拉取的模型即可(系统会自动检测Ollama拉取的模型,非常方便,无需额外手动配置)。

点击设为默认这样每次我们就不用手动去选择模型了!!

选择好模型之后我们直接页面文本框中进行提问即可!!

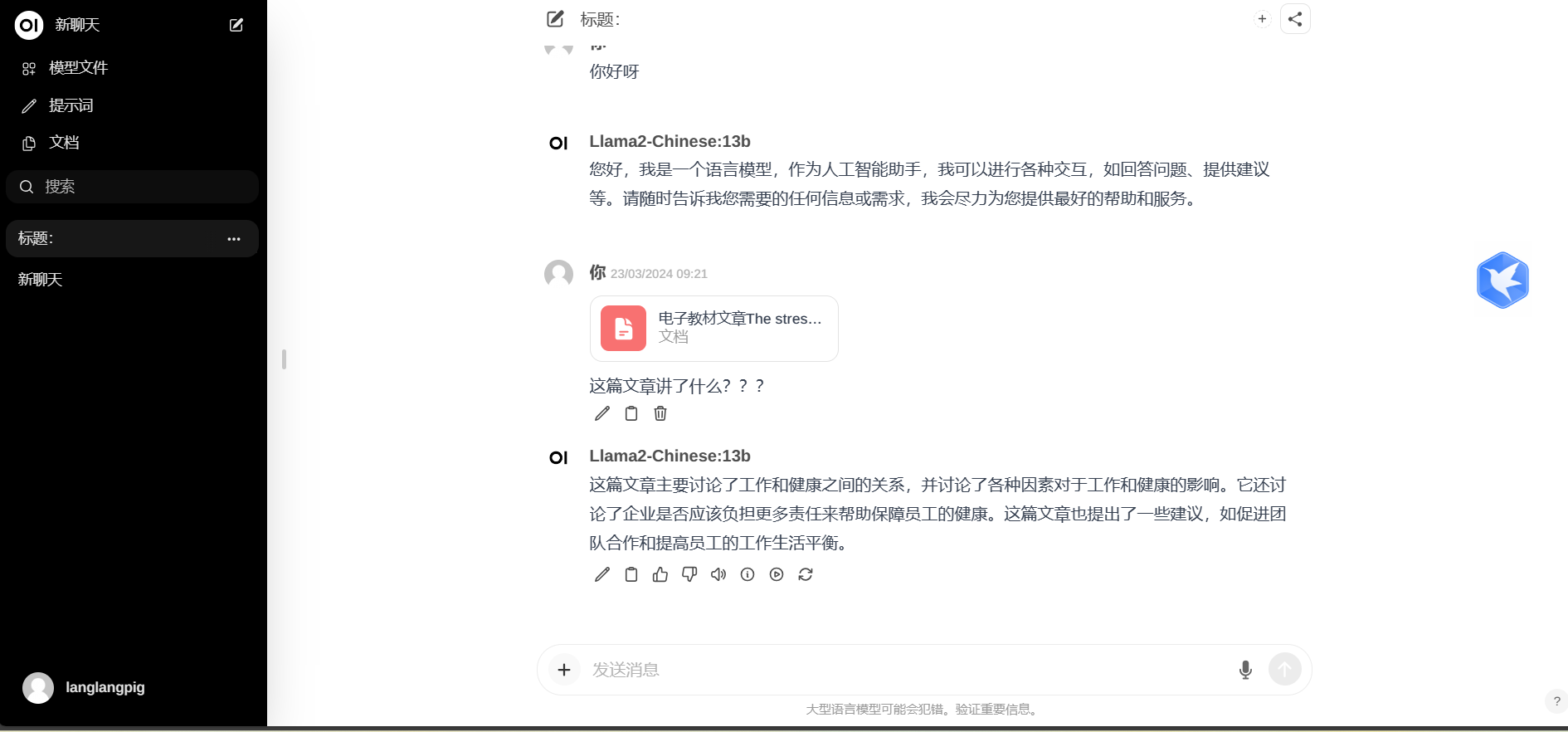

当然我们也可以点击文本栏的➕来上传本地word文件来让AI帮助我们分析:

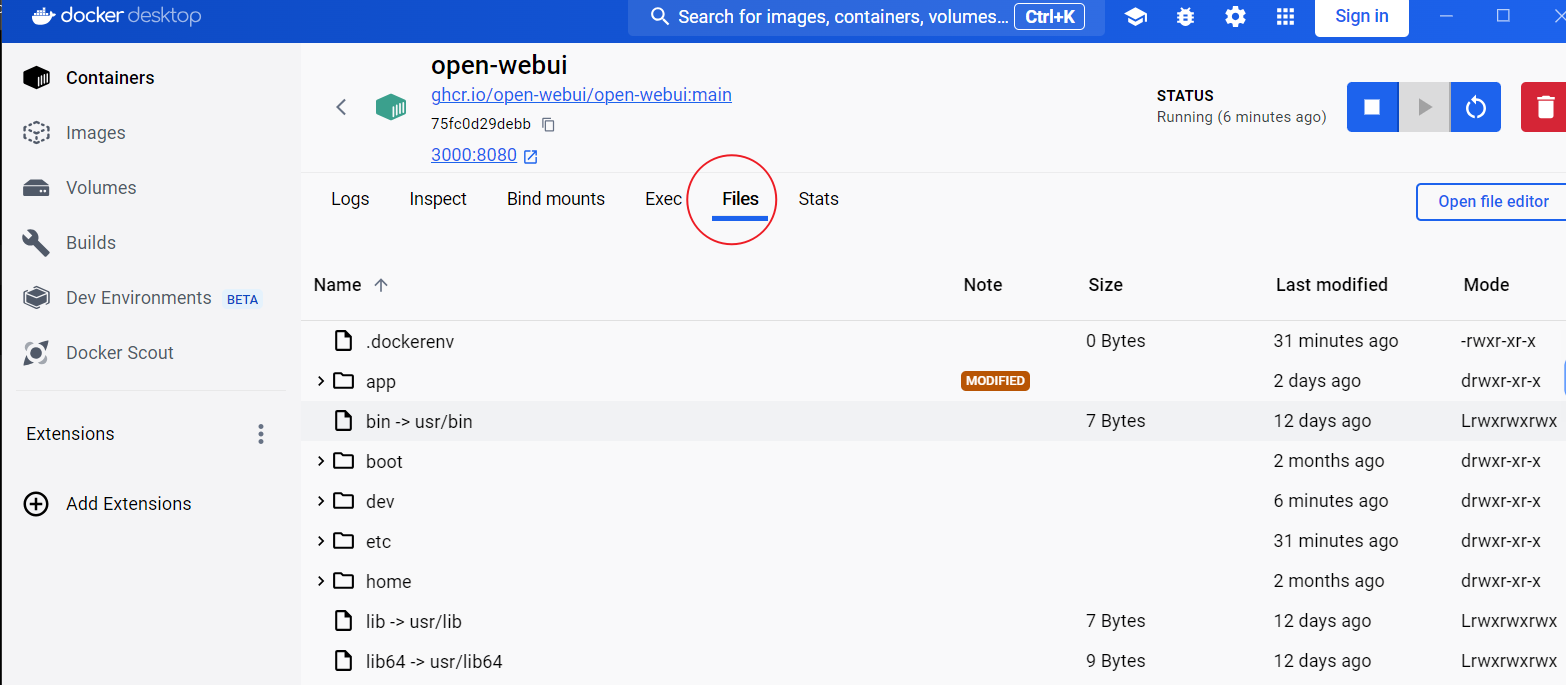

最后你是不是好奇我这些数据都存在哪里了???Okey,接下来我就带你去找找。

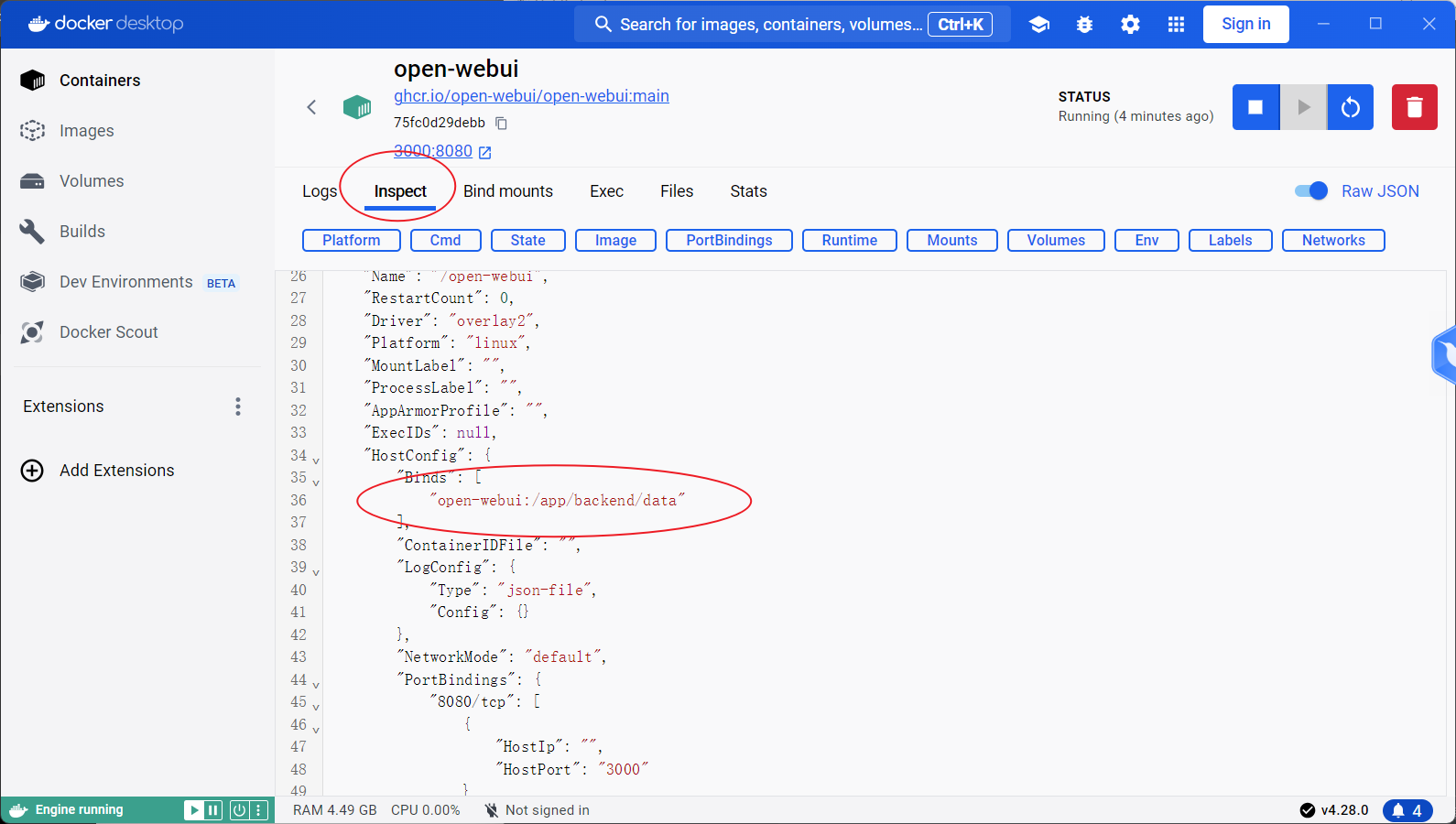

首先我们打开DockerDesktop,然后点击Containers

我们可以看到点击Open-webui,进入之后我们点击Inspect

我们可以在配置文本语句中看到,我们的数据是存在docker容器的文件中的:

/app/backend/data可以看到我们刚刚上传的文件已经在/app/backend/data"的uploads文件夹下存着了。

以上就是Ollama部署+OpenWeUI图文流教程了,更多OpenWebUI的玩法等你去开发!!!!

FQA

Q1

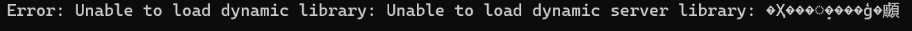

在拉去大模型的时候我们可能会遇到如下图的错误:

报错的关键词是:

A1

出现这个情况的原因呢就是在你创建windows系统的时候系统会让你输入一个昵称的,那时候你可能输入了一个中文名,然后系统根据这个中文名在C盘自动创建了系统用户文件夹,比如上图中显示中文名是”苏梦宸“,这就导致其无法被系统识别不出来了,毕竟是老外的系统,对中文有时候编码格式不对会识别不出来的,解决方案呢就是把C盘中的系统用户文件夹名字改成英文的,这个建议去网上找找教程,我自己没遇到过这个情况,我给出的解决方案是直接重装系统省事,嘿嘿。

文章标题:本地大模型工具Ollama+OpenWeUI部署图文流教程

文章链接:https://www.langlangshan.cloud/?post=29

本站文章均为原创,未经授权请勿用于任何商业用途

推荐阅读: